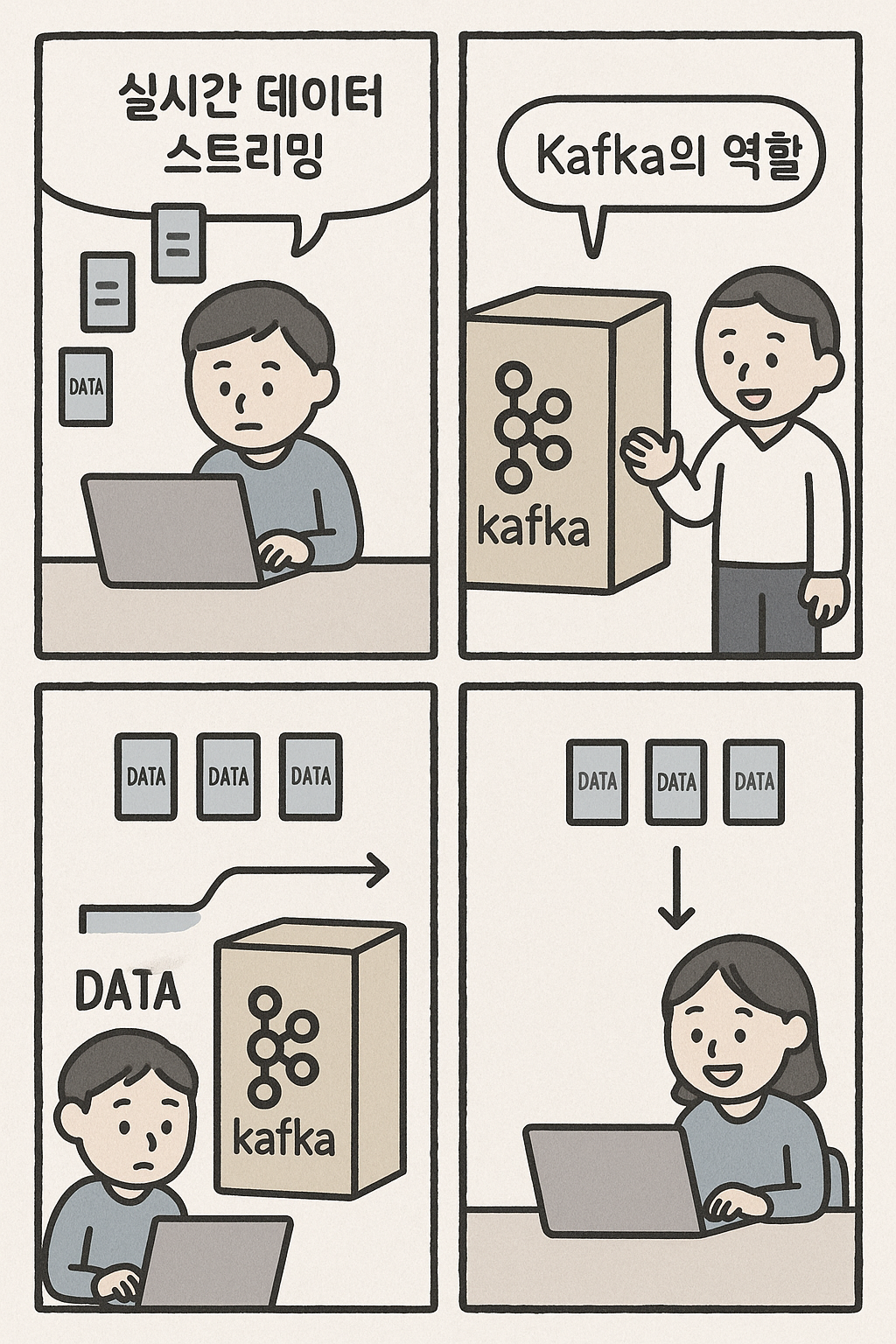

과거에는 데이터를 특정 시점에 모아서 한꺼번에 처리하는 배치 처리(Batch Processing)가 일반적이었습니다. 하지만 4차 산업혁명 시대가 도래하면서, 데이터는 더 이상 정적인 '호수'가 아니라 끊임없이 흐르는 '강물'이 되었습니다. 사용자 행동, IoT 센서, 금융 거래 등 실시간으로 발생하는 방대한 양의 데이터를 즉시 처리하고 분석하는 실시간 데이터 스트리밍(Real-time Data Streaming)의 중요성이 폭발적으로 증가했습니다. 이 거대한 데이터 흐름을 안전하고 효율적으로 관리하는 핵심 기술이 바로 Apache Kafka입니다.

실시간 데이터 스트리밍이란 무엇인가?

실시간 데이터 스트리밍은 데이터가 생성되는 즉시 수집, 전송, 처리, 분석되는 일련의 과정을 의미합니다. 이는 사용자 클릭, 금융 거래, 기계 로그, IoT 기기 상태 업데이트 등과 같은 연속적인 데이터 스트림을 다루는 데 최적화된 방식입니다.

- 배치 처리와의 차이점: 배치 처리는 특정 기간(예: 하루) 동안 쌓인 데이터를 한꺼번에 처리하므로 결과가 늦게 나옵니다. 반면, 실시간 스트리밍은 데이터가 발생하는 즉시 처리하므로, 실시간 이상 감지, 개인화 추천, 사기 거래 탐지 등 즉각적인 반응이 필요한 서비스에 필수적입니다.

Apache Kafka: 실시간 데이터의 중앙 허브 🧠

Apache Kafka는 링크드인(LinkedIn)에서 개발된 분산 이벤트 스트리밍 플랫폼입니다. 간단히 말해, 대규모 데이터를 실시간으로 안정적이고 확장성 있게 주고받을 수 있는 중앙 허브 역할을 합니다. Kafka는 전통적인 메시지 큐와는 달리 데이터를 영속적으로 저장하는 분산 커밋 로그(Distributed Commit Log) 아키텍처를 채택하여 독보적인 강점을 가집니다.

- Kafka의 핵심 구성 요소:

- Producers (생산자): 데이터를 Kafka에 발행(publish)하는 애플리케이션입니다.

- Consumers (소비자): Kafka에 발행된 데이터를 구독(subscribe)하여 처리하는 애플리케이션입니다.

- Brokers (브로커): Kafka 서버의 한 단위로, 데이터를 저장하고 관리합니다. 여러 브로커가 클러스터를 구성하여 분산 시스템을 이룹니다.

- Topics (토픽): 데이터가 저장되는 논리적인 카테고리입니다. 각 토픽은 여러 개의 파티션(Partition)으로 나뉘어 데이터 처리를 병렬화합니다.

Kafka의 핵심 역할과 독보적인 장점 ⭐

Kafka가 수많은 기업들의 데이터 인프라의 '심장'이 된 이유는 다음과 같은 독보적인 장점 때문입니다.

- 높은 처리량(High Throughput): Kafka는 디스크에 순차적으로 데이터를 기록하는 방식으로, 초당 수십만 건의 메시지를 처리할 수 있는 놀라운 성능을 자랑합니다. 이는 웹 트래픽, IoT 센서 등 폭발적인 양의 데이터를 처리하는 데 매우 효과적입니다.

- 뛰어난 확장성(Scalability): 데이터 양이 증가하면 Kafka 클러스터에 브로커를 추가하고, 토픽의 파티션 수를 늘리는 방식으로 손쉽게 확장할 수 있습니다. 이는 하드웨어 추가만으로 선형적인 성능 향상을 보장합니다.

- 강력한 내결함성(Fault Tolerance): Kafka는 데이터를 여러 브로커에 복제하여 저장합니다. 따라서 특정 브로커에 장애가 발생하더라도 데이터가 유실되지 않으며, 다른 브로커가 그 역할을 인계받아 시스템 전체의 안정성을 유지합니다.

- 영속성(Persistence): 기존 메시지 큐는 소비자가 메시지를 읽으면 데이터를 삭제하는 휘발성 구조가 많았습니다. 하지만 Kafka는 데이터를 디스크에 저장하여 정해진 기간 동안 보존합니다. 이는 소비자가 언제든 과거 데이터를 다시 읽을 수 있게 하며, 장애 발생 후에도 데이터 재처리가 가능하게 합니다.

- 다양한 생태계: Kafka는 단순한 메시징 시스템을 넘어, 실시간 데이터 처리 파이프라인을 구축하는 데 필요한 풍부한 도구 생태계를 제공합니다. Kafka Connect는 다양한 데이터 소스와 쉽게 통합할 수 있게 하고, Kafka Streams는 실시간으로 데이터를 가공하고 분석하는 애플리케이션을 구축할 수 있게 합니다.

Kafka가 해결하는 실제 문제들

Kafka는 이미 다양한 산업에서 핵심적인 역할을 수행하고 있습니다.

- 로그 및 이벤트 수집: 수천 대의 서버에서 발생하는 모든 로그와 이벤트를 중앙 집중적으로 수집하고 분석하는 데 사용됩니다.

- 실시간 분석: 전자상거래 기업에서 사용자의 클릭, 구매, 검색 데이터를 실시간으로 분석하여 개인화된 추천 상품을 제공합니다.

- 마이크로서비스 간 통신: 마이크로서비스 아키텍처에서 서비스 간의 결합도를 낮추는 메시지 버스 역할을 합니다. 예를 들어, '주문' 서비스에서 발생한 이벤트를 '결제' 서비스와 '배송' 서비스가 비동기적으로 구독하여 처리할 수 있게 합니다.

- IoT 데이터 처리: 수많은 IoT 센서에서 발생하는 데이터를 실시간으로 수집하고 처리하여, 이상 감지나 장비 상태 모니터링에 활용합니다.

결론: Apache Kafka는 높은 처리량, 확장성, 내결함성, 그리고 영속성이라는 독보적인 강점을 바탕으로 실시간 데이터 스트리밍 분야의 표준으로 자리 잡았습니다. 데이터가 기업의 핵심 자산이 된 지금, Kafka는 데이터를 단절된 '파일'이 아닌 살아있는 '흐름'으로 만들어, 실시간으로 비즈니스 가치를 창출하는 현대 데이터 인프라의 심장 역할을 수행하고 있습니다.

'개발' 카테고리의 다른 글

| 오픈소스의 힘: GitHub 스타 수로 보는 인기 프로젝트와 그 의미 ✨ (2) | 2025.08.17 |

|---|---|

| 데이터 엔지니어 vs. 데이터 사이언티스트: 두 직업의 차이와 협업 방식 🤝 (2) | 2025.08.17 |

| Rust가 떠오르는 이유와 실제 사용 사례 🦀 (1) | 2025.08.16 |

| JavaScript 비동기 처리: Promise vs async/await 완벽 가이드 📜 (5) | 2025.08.16 |

| 파이썬에서 자주 쓰이는 디자인 패턴 5가지 🐍 (2) | 2025.08.16 |